В основе работы Reface технологии искусственного интеллекта и алгоритмов машинного обучения, которые берут созданное пользователем селфи и вставляют его в выбранное им видео

Месяц: Сентябрь 2020

Хакеры используют машинное обучение, чтобы клонировать чей-то голос, а затем объединить этот клон голоса с методами социальной инженерии. Это дает мошенникам возможность убедить людей перевести средства туда, где им не место. Такие схемы обмана были успешны в прошлом, но насколько хороши голосовые клоны, используемые в этих атаках?

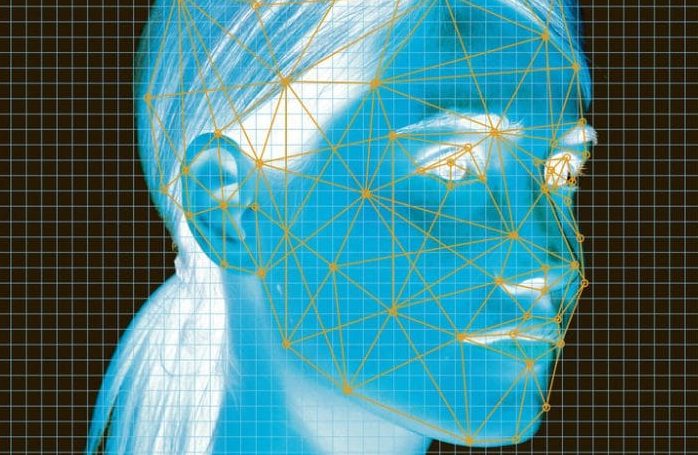

– Объективно для точности распознавания хотя бы на 60-70% необходимо, чтобы алгоритмам системы нейронного обучения было видно для обработки как минимум 50% лица.

Было бы честно сначала всем потенциальным пользователям ЕБС показывать это видео, а потом спрашивать согласие «стать клиентом банков и получать услуги без посещения офисов и предъявления паспорта — с помощью биометрии (лица и голоса) через Интернет»

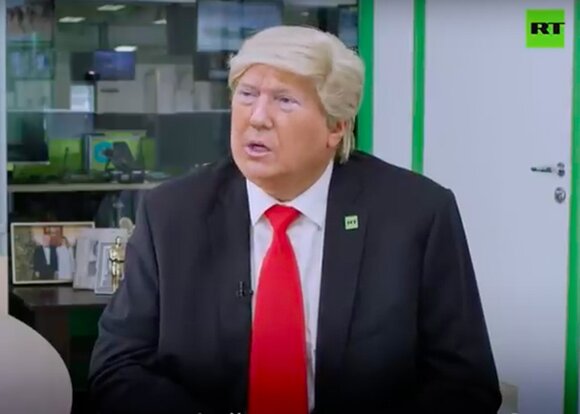

В ролике Трампа играет похожий на него актер. Для реалистичности использована технология deepfake, когда изображение или видео накладывается и адаптируется под голос или действия другого человека. Перед разработчиками не ставили задачу сделать героя ролика похожим на Трампа, чтобы не вводить в заблуждение читателей

Puppets.World можно скачать в App Store и использовать совершенно бесплатно. Для создания роликов длиной больше 30 секунд

Отмечается, что бдительность притупила фотография его знакомого – российского бойца смешанных боевых искусств на аватарке мошенника

Клиенту необходимо оплатить одежду на сайте, после чего прислать свой снимок работникам бренда. Последние «наденут» на него выбранные вещи с помощью фотошопа. В результате покупатель получит фотографию в 3D-наряде, похожем на настоящую одежду. При этом у него не будет возможности надеть вещи в реальной жизни. Визуально выглядит достаточно слабо. PhotoShop – это не deepfake.

Решение биометрического распознавания лиц Knomi от Aware прошло тестирование уровня 1 и 2 на обнаружение презентационных атак (PAD) при оценке технологии iBeta

В сети стали появляться объявления о поиске разработчиков deepfake видео. Пока такие объявления размещают на сайтах фрилансеров.

В последнее время, к технологии «Deepfake» возрос небывалый интерес: на рынке появились доступные приложения в смартфонах или ПК, которые превращают пользователя в любимого вымышленного героя или знаменитость, состаривают или молодят, изменяют голос, добавляют к любой картинке спецэффекты и многое другое

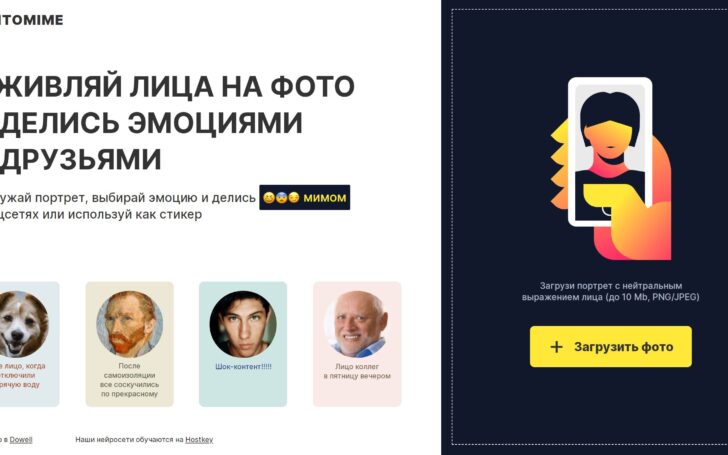

Пользователь может воспользоваться не только шестью базовыми эмоциями, а выбрать любое из двадцати предлагаемых вариантов. Например, “флирт”, “сарказм” или удивление

Онлайн-магазин Replicant.Fashion, созданный дизайнером Региной Турбиной, будет продавать виртуальные наряды стоимостью в 999 рублей

Всё это может звучать довольно безобидно. Тем не менее, данная технология будет иметь значительные и, возможно, трагические последствия. С помощью дипфейк, например, можно будет создать фальшивые видео с фальшивыми политиками, которые всего лишь несколькими выдуманными фразами смогут вызывать общественные беспокойства, кризисы на биржах, войны, погромы против меньшинств. Не исключено, что с помощью дипфейк целые общества и демократии будут ввергнуты в хаос.

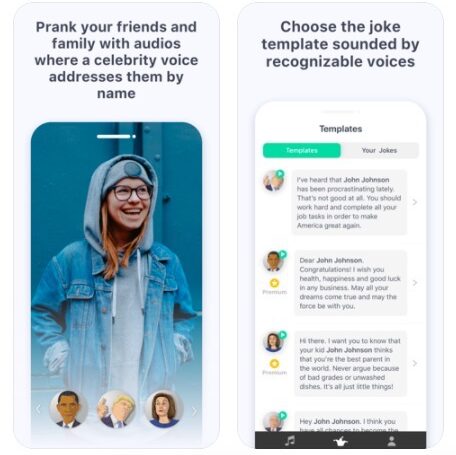

Чтобы создать свое сообщение, нужно набрать его в разделе «Свой текст» на русском или английском языках и нейросеть Parodist синтезирует его в речь

NeRF-W основана на NeRF — первоначальной работе исследователей, которая позволяла делать то же самое, но работала нормально только в строго заданных контрольных условиях. Технология строит карты глубины резкости с помощью нейросетей, а потом синтезирует объёмную сцену с помощью прямого 3D-рендеринга

С каждым годом создавать фейки становится всё проще. Например, уже сегодня можно смонтировать видео якобы со скрытой камеры, где человек признается в чём угодно

Британский журналист Тристан Кросс воссоздал в виртуальной реальности свой любимый паб, куда он часто ходил до пандемии коронавируса

Мы ожидаем, что методы создания синтетических медиа будут продолжать совершенствоваться. Мы должны понимать и быть готовыми реагировать на дипфейки

Компания Nuki продемонстрировала интеллектуальный электронный дверной замок с биометрическим распознаванием лиц и обнаружением живучести от BioID, говорится в сообщении компании в блоге.

Количество дипфейков – медиа, которые берут существующее фото, аудио или видео и заменяют личность человека на нем на чужую с помощью ИИ – очень быстро растет.

Специализированные форумы ДАРКНЕТА предлагают подборку из нескольких программ, которые помогут самостоятельно подделать чужой голос