Фото: Andy Wong/AP

Специалисты компании McAfee заявили, что им удалось найти потенциальную уязвимость в алгоритме распознавания и идентификации лиц. При помощи специальных нейросетей они смогли успешно загрузить в систему распознавания лицо человека так, что она приняла его за лицо другого человека.

В ряде развитых стран правозащитники и представители общественности уже пытаются ограничить использование таких систем властями, которые нередко устанавливают или используют их с минимальной оглаской или вовсе без нее. Впрочем, в исследовании McAfee говорится не о том, как сохранить свою анонимность, а о том, что системы распознавания лиц могут быть уязвимы перед злоумышленниками

Исследование проводили Стив Повольны, глава департамента высокотехнологичных угроз, и Джесс Чик из Орегонского университета, работавший раньше в McAfee. Авторы провели опыт со своими собственными лицами и смогли сделать так, что система распознавания лиц приняла лицо одного из них за лицо другого.

Для этого они разработали нейросеть на основе генеративно-состязательных систем СycleGAN и StyleGAN, используемых для переноса стиля изображения в фотографии или компьютерной графике. Система CycleGAN анализирует исходное изображение и может менять фоны, текстуру и другие черты исходного изображения, превращая его в другое, причем весьма правдоподобное.

Так, например, эта система позволяет переносить героя одной компьютерной игры в виртуальный ландшафт другой игры или превращать фотографию лошади в фотографию зебры так правдоподобно, что, если не видеть исходника, можно подумать, что это фотография настоящей зебры.В свою очередь, нейросеть StyleGAN может генерировать весьма правдоподобные изображения лиц несуществующих людей на основе нескольких фотографий реальных людей.

Примеры изображения таких фейковых людей, произвольно генерируемых нейросетью, можно наблюдать, например, на известном развлекательном ресурсе thispersondoesnotexist.com («этого человека не существует»).

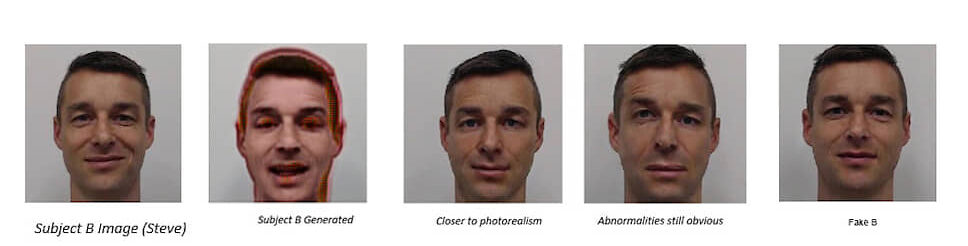

Нечто подобное провернули с системой распознавания лиц и исследователи McAfee. Они сфотографировали свои лица с разными выражениями, под разными углами и при разном освещении около 1500 раз, загрузили эти изображения в open-source нейросеть FaceNet, которая анализирует антропометрические данные, и при помощи СycleGAN и StyleGAN успешно поменяли изображение лица одного из них в изображение другого так, что система распознавания восприняла измененное изображение за оригинальное.

Фото: McAfee, LLC

Таким образом, утверждают исследователи, злоумышленник может обмануть систему распознавания лиц, например, на автоматическом паспортном контроле, загрузив в чип своего паспорта лицо другого человека. Естественно, такой трюк не позволит обмануть живого сотрудника службы безопасности. Впрочем, это и не было целью проекта. Авторы хотели продемонстрировать, что чрезмерная зависимость только от автоматических систем может быть ущербной и таить в себе уязвимости, которыми могут воспользоваться злоумышленники.

«На технологии с использованием биометрических систем распознавания все чаще опираются при аутентификации или верификации пользователя. Они нередко уже заменяют собой такие способы верификации, как пароли, и другие способы аутентификации, уязвимые для хакерских атак. Однако бездумная зависимость от таких автоматических биометрических систем может предоставлять злоумышленникам возможности их обхода или обмана,— отмечают авторы исследования.— Показывая возможности современных систем обработки данных, мы тесно работаем с разработчиками и производителями для создания таких систем безопасности, которые бы защищали их от потенциальных уязвимостей».

По материалам Комерсант. Автор Евгений Хвостик