Deepfake — это технология замены аудио- и видеоряда, громко заявившая о себе в 2017 году. С её помощью президентов США заставляли оскорблять друг друга, а известную актрису вставили в эротический ролик. И всё благодаря стараниям современного искусственного интеллекта — нейросетей. Сегодня я расскажу в деталях, что такое дипфейк, опасен ли он и что нас ждёт в будущем.

Опасность для мира

В отличие от пресловутого Фотошопа, дипфейк представляет куда большую опасность для общества. И это даже не беря в расчёт моральный ущерб от того, что лица людей подставляют в порнофильмы.

Взять, например, метод целевого фишинга. Это когда человека обманывают с помощью личной информации, чтобы получить выгоду. К примеру, отправляют работнику послание «от шефа», в котором говорится перевести деньги компании на указанный счёт. Вряд ли кто-то поведётся, если это будет простое сообщение в мессенджере. Но когда начальник говорит подобное своим голосом — тут уж подозрений не возникнет. И что самое пугающее, прецеденты уже случались.

Можно ли с этим бороться?

Впрочем, подобные технологии не могли остаться без внимания. В ряде стран уже принимаются законы, ограничивающие использование технологии Deepfake. Во многих компаниях вводятся внутренние правила против фишинга. Впрочем, законы — это, конечно, хорошо. Но можно ли бороться с фейками активнее? Да, и это уже делают.

Сперва стоит пояснить, что большие корпорации, развивающие эту технологию, параллельно учатся ей противостоять. Это обязательный процесс, когда появляются опасные программы. Однако лучше всего бороться с искусственным интеллектом может лишь он сам.

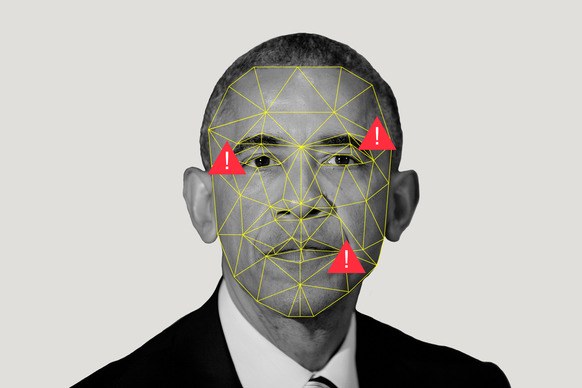

Целый ряд разных организаций, таких как Amazon, Google и даже Минобороны США, учат нейросети определять фейки других нейросетей. Порой в этом помогают и люди. К примеру, проходил конкурс на определение видео-обманок. Его целью было вовсе не развлечение участников — их ответы скармливали ИИ, чтобы тот на них учился.

Подобные исследования имеют и приятные побочные эффекты. Взять хотя бы нейросеть, которая умеет определять, какие области фото были отредактированы через Фотошоп.

Будущее с Deepfake

Но что же станет с миром через десяток другой лет? Неужели в интернете совсем ничему нельзя будет верить? Вместо ответа хочется просто напомнить о существовании того же Photoshop. Он в своё время тоже сильно изменил мир. Тем не менее человечество адаптировалось, как сможет привыкнуть и к технологии Deepfake. К тому же у вопроса есть и светлая сторона! Границы возможного для кино, игр и музыки размоются ещё сильнее с развитием «обманного» инструментария!

По материалам «Ридер». Автор Антон Гуртовой