Исследователи Nvidia AI представили систему, которая создает анимирует лица для видеоконференций всего из одного 2D-изображения. Авторы разработки говорят, что алгоритм способен выполнять широкий спектр манипуляций, включая вращения и перемещения головы человека.

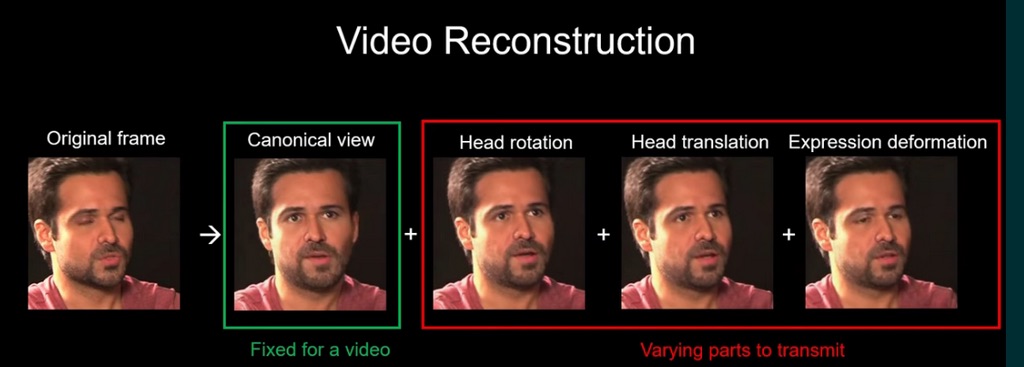

ИИ использует первый кадр в видео как 2D-фотографию, а затем методом самостоятельного обучения собирает ключевые 3D точки в видео. Преобразуя эти ключевые точки, система демонстрирует более высокие коэффициенты сжатия, чем прежние существующие методы передачи изображения.

Система обеспечивает качество видео H.264, используя одну десятую пропускной способности, которая ранее требовалась при подобных операциях.

В октябре Nvidia показала Maxine, сервис видеоконференцсвязи. Помимо виртуальных фонов, как в Zoom, он предоставит набор функций на базе искусственного интеллекта, таких как выравнивание лиц и шумоподавление, диалоговый аватар AI или живой перевод.

Nvidia активно работает над генеративными состязательными моделями (GAN), такими как StyleGan. Эти модели потенциально можно применять в сферах развлечений и игр, а также для создания дипфейков.

Компания работает с технологией синтеза видео в видео (vid2vid), которая направлена на преобразование входного семантического видео в выходное фотореалистичное. Существующие подходы имеют два основных ограничения. Во-первых, им нужны данные, а для обучения —многочисленные изображения целевого объекта или сцены. Во-вторых, у модели ограничены возможности обобщения. Определенная модель vid2vid может синтезировать только позы одного человека в обучающей выборке.

В новой представленной системе возможность краткого обобщения достигается с помощью нового модуля генерации веса, использующего механизм внимания.

Летом в Disney Research представили нейросеть, которая заменяет лица на фотографиях и в видео в полностью автоматизированном режиме. Дипфейк реалистично копирует мимику и речь оригинала.

Весной программист разместил видео, в котором он подставляет себе лицо Илона Маска и участвует в различных видеоконференциях Zoom. Для создания дипфейка использовался открытый исходный код «First Order Motion Model for Image Animation». Алгоритм подстраивает изображение в реальном времени, без предварительного «знакомства» с несколькими фотографиями подставляемого лица.

По материалам habr.com. Автор maybe_elf