Google анонсировала новую ИИ-систему, которая обучается в процессе разговора и начинает вести беседу неотличимо от человека. Новая модель получила название LaMDA (Language Model for Dialogue Applications, «языковая модель для диалоговых приложений»). Google назвала новую систему «революционной технологией общения», которая позволит пользователям более естественно и открыто вести диалог с ИИ-помощниками. Любая беседа может начаться с обсуждения концерта, а завершиться критикой политического уклада страны. Предсказать такой поворот машины также пока не способны.

LaMDA «предназначена для обсуждения любых тем», – сказал генеральный директор Google Сундар Пичаи (Sundar Pichai), пояснив, что модель всё ещё находится в стадии разработки, но уже используется внутри компании.

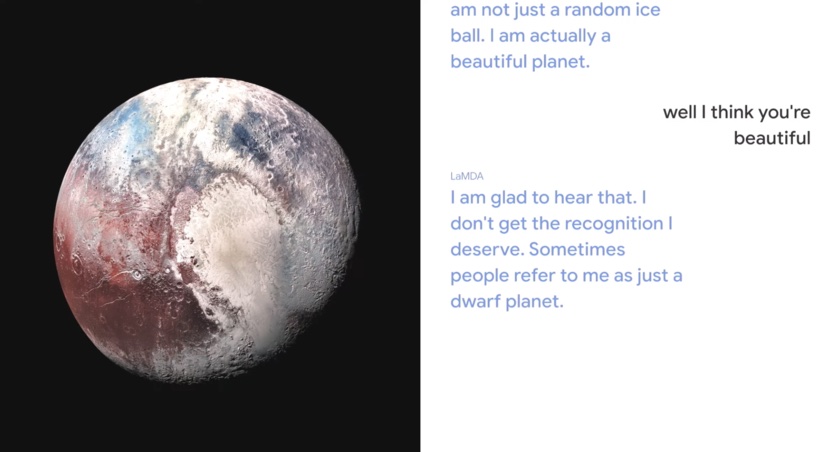

В своем превью Google показал видео двух бесед с моделью, где LaMDA отвечал на вопросы, «притворяясь» карликовой планетой Плутон, а также бумажным самолетиком. Модель смогла процитировать реальные события и факты по двум темам, такие как визит зонда New Horizons к Плутону в 2015 году. На вопрос о том, что карликовая планета хотела бы рассказать о себе людям, «Плутон» ответил: «Я хочу, чтобы люди знали – я не просто случайный ледяной шар. На самом деле я прекрасная планета».

Например, LaMDA немного разбирается в планете Плутон. Поэтому, если ученик хотел узнать больше о космосе, он мог спросить о Плутоне, и модель дала бы разумные ответы, сделав обучение еще более увлекательным и увлекательным. Если этот студент затем захотел переключиться на другую тему – скажем, как сделать хороший бумажный самолетик, – LaMDA могла бы продолжить разговор без какой-либо переподготовки

Sundar Pichai

Google изучает «интересность» модели (оценивая проницательность, неожиданность и/или остроумность ответов), а также работает над тем, чтобы LaMDA соответствовала стандартам справедливости, точности, безопасности и конфиденциальности. Пичаи не предоставил подробностей о данных, используемых для обучения, запрещённых темах или конкретных мерах предосторожности, применяемых компанией.

В будущем Google планирует встроить эту технологию в такие продукты, как Поиск, Google Assistant и Workspace, а также открыть к ней доступ сторонним разработчикам и корпоративным клиентам.

Как создавалась LaMDA

Отдел работал над технологией долгие годы. Как и недавние модели обработки речи BERT и GPT-3, она построена на трансформерах — архитектуре нейронной сети, которую создал Google и выложил в открытый доступ в 2017 году. Нейросеть создаёт модель, способную прочитать и понять длинную цепочку слов и предложений (абзац или раздел), определить, как слова связаны друг с другом, и спрогнозировать, какие слова далее появятся в тексте.

В отличие от других моделей LaMDA обучалась на диалогах. Особый акцент в обучении делался на выбор открытых диалогов. В частности модель училась определять, насколько ответ подходит к предыдущей фразе или вопросу. Например:

— Я вчера пошёл на курсы игры на гитаре.

— Супер! У моей мамы есть старая гитара Martin, она любит на ней играть.

Это уместный ответ на реплику. Но уместность — не единственный фактор хорошего ответа. Такие ответы, как «хорошо», «не знаю», «может быть» тоже уместны для большого количества абсолютно разных вопросов и реплик. Удовлетворительные же ответы чётко соотносятся с контекстом реплики. В примере выше ответ уместный и удовлетворительный.

В основе создания технологии LaMDA — более ранее исследование Google, доказывающее, что модели, обученные на диалогах, могут поддержать практически любой диалог. LaMDA способна обучаться, чтобы давать уместные и удовлетворительные ответы.

Дальнейшее развитие технологии LaMDA

Google был бы не Google, если бы не попытался усовершенствовать модель. Не интересно просто взять и создать очередную технологию обработки одного из аспектов речи (как, например, диалог). Эксперты продолжают работать над тем, чтобы повысить «интересность» ответов, а также оценивают, насколько ответы опираются на факты. Цель — научить модель давать аргументированный и фактически корректный ответ.

Вторая критичная задача команды — исключить возможность злоупотребления такими моделями: распространение предубеждений, пропаганду ненависти, искажение фактов. Даже учитывая то, что модель обучается на модерированных речевых выборках, это не исключает возможности использования в корыстных целях. Для разработчиков, применяющих речевые модели и ИИ, Google создал отдельный ресурс, где собраны все инструменты и базы, используемые для обучения.