Исследователи из лаборатории SAND Lab при Чикагском университете утверждают, что доступные широкой общественности программы клонирования голоса развиваются угрожающе быстро. В частности, создаваемые при помощи подобных технологий голосовые дипфейки могут сбить с толку как людей, так и смарт-устройства с голосовым управлением. Но не только голосовые, а также и другие дипфейки представляют угрозу. Дипфейки уже используются в рекламе, моде, журналистике и обучении. Однако больше 90% подделок созданы, чтобы навредить репутации, — например с помощью порнографических роликов. В 2019 году общие денежные потери бизнеса из-за дипфейков приблизились к отметке $250 млн в 2020 году.

Примеры атак с использованием дипфейков

- Атака на руководителя энергетической компании: Эта афера с использованием дипфейка в 2019 году является первой известной атакой с использованием данной технологии, и она иллюстрирует «темную» сторону возможностей технологии дипфейков. Как в классическом случае корпоративного вымогательства, генеральный директор энергетической фирмы получил телефонный звонок якобы от своего босса. На самом деле, это был поддельный голос, сгенерированный искусственным интеллектом, но на слух это невозможно было определить, поэтому генеральный директор спокойно выполнил его поручение о переводе 243 000 долларов США в течение часа. Программа смогла сымитировать не просто голос человека, но его тональность, интонации и немецкий акцент. Правда вскрылась, когда мошенники попытались провернуть тот же фокус во второй раз. Увы, полиция не смогла идентифицировать личности преступников, а вместе с ними не удалось найти и деньги.

- Атака на техническую компанию: В этой неудачной попытке аудио-дипфейка в 2020 году сотрудник одной технической компании получил странное голосовое сообщение от кого-то, чей голос был очень похож на голос генерального директора фирмы. В сообщении содержалась просьба о «немедленной помощи для завершения срочной деловой сделки». Однако сотрудник компании, следуя своим подозрениям, сообщил об этом в юридический отдел фирмы. Хотя эта атака с использованием дипфейка в конечном счете не увенчалась успехом, но она является ярким примером тех типов атак, которые мы ожидаем увидеть в большом объеме по мере того, как технологические достижения и инструменты для создания дипфейков будут становиться все более доступными. Письма на электронной почте и голосовые дипфейки оказались частью продуманной мошеннической операции, в которой, по данным полиции ОАЭ, были задействованы не менее 17 человек из разных стран.

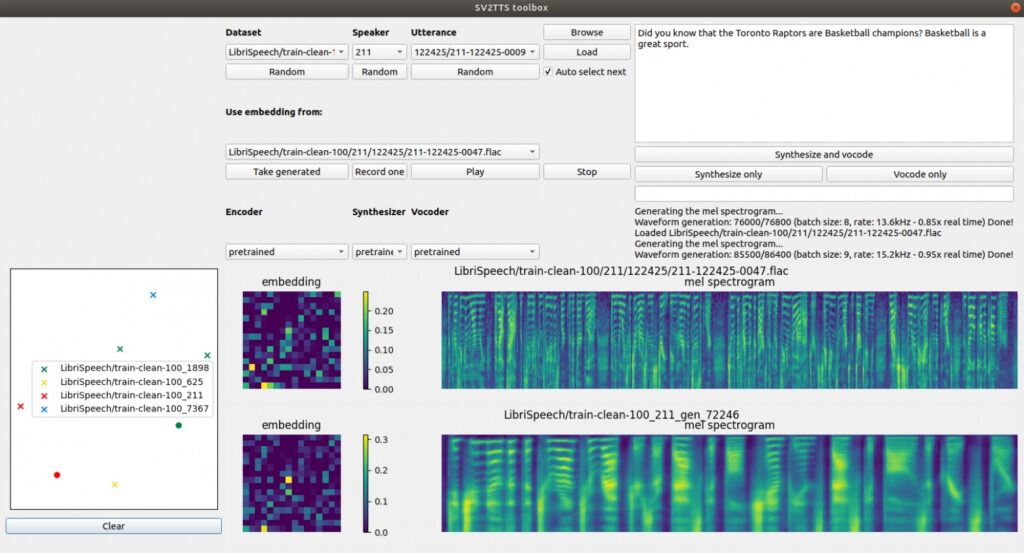

Команда экспертов из лаборатории SAND Lab (Security, Algorithms, Networking and Data Lab) протестировала доступные на платформе Github программы клонирования голоса, чтобы узнать, смогут ли они прорваться сквозь защиту системы безопасности распознавания голоса умных колонок Alexa, WeChat и Azure. Среди множества программ внимание учёных привлекла технология SV2TTS, создатели которой называют её «инструментом для клонирования голоса в режиме реального времени». По словам разработчиков, программа SV2TTS может синтезировать полноценные голосовые дипфейки, основываясь всего на 5 секундах записи оригинального голоса. Имитация голоса в исполнении SV2TTS смогла обойти защиту Azure от Microsoft в 30% случаев, а колонки Alexa и WeChat поддавались обману и того чаще – в 63%. Не менее ошеломляющие результаты показал эксперимент с 200 волонтёрами: примерно в половине случаев люди не смогли отличить голосовые дипфейки от реальных голосов.

Кроме того, исследователи пришли к выводу, что по какой-то причине синтезаторам речи гораздо лучше удаётся имитировать женские голоса, а также речь людей, для которых английский язык не является родным. По словам исследователей, современные механизмы защиты против синтезированной речи развиваются медленнее технологий имитации голоса. Не в тех руках подобные программы рискуют стать инструментом воплощения преступного замысла. При этом мишенью атаки могут стать как реальные люди, так и смарт-устройства. К примеру, колонка WeChat использует распознавание голоса пользователя для обеспечения доступа к платным функциям, например, для проведения транзакций в приложениях сторонних разработчиков вроде Uber или New Scientist.

Впрочем, изначально голосовые дипфейки заинтересовали учёных после новостей об использовании технологий имитации голоса для проворачивания крупных финансовых махинаций, о которых сказано выше.

Джейк Мур – эксперт в отрасли информационной безопасности из компании ESET – считает, что голосовые и видео-дипфейки представляют реальную угрозу безопасности информации, хранения денег и деловых отношений на глобальном уровне. По мнению Мура, в обозримом будущем всё больше предприятий будут становиться жертвами высокотехнологичной преступной деятельности. К счастью, по мере осознания опасности недобросовестного использования ИИ-технологий на рынке стали набирать популярность компании вроде Pindrop Security, которые предлагают клиентам помощь в идентификации звонков, осуществляемых при помощи технологий имитации голоса.

А как дело обстоит с фото или видео дипфейками?

Зачастую — это порнографический шантаж. Жертвами регулярно становятся знаменитости. Например, в числе жертв злоумышленников — Натали Портман, Тейлор Свифт, Галь Гадот и другие. Но подделывают внешность и голос не только известных людей.

В 2021 году в Индии стали все чаще происходить случаи мошенничества с использованием видеозвонков, в процессе которых женщина раздевается на камеру и побуждает мужчину делать то же самое. Жертву записывают на видео и потом шантажируют, вымогая до 2 млн рупий. Полиция города Ахмедабад обнаружила, что в 60% случаев жертвы говорили не с реальными женщинами, а с дипфейками. Мошенники используют программы, которые переводят текст в аудио и, предположительно, видео с порносайтов.

Частое опасение, связанное с дипфейками, — что они будут использоваться в политических целях. Такие примеры уже есть, и речь не про знаменитый дипфейк Обамы, в котором он обзывает Трампа. В феврале 2020 года, за день до выборов в Законодательное собрание в Нью-Дели, дипфейк-видео главы одной из ведущих общенациональных партий Индии стали вирусными в WhatsApp. В одном из них он говорил на диалекте хинди, хариани. Это видео использовалось, чтобы отговорить рабочих-мигрантов голосовать за другую партию. Дипфейки распространили в 5,8 тыс. групп WhatsApp в Дели и Национальном столичном регионе, охватив примерно 15 млн человек.

Другой интересный пример: видео с экс-премьер-министром Бельгии Софи Вильмес, которое опубликовала организация Extinction Rebellion Belgium. Этот дипфейк — модификация предыдущего обращения к нации по поводу пандемии. В вымышленной речи говорится, что последние глобальные эпидемии напрямую связаны с «эксплуатацией и разрушением людьми природной среды». Для воспроизведения голоса и манеры речи использовался ИИ.

Можно ли отличить дипфейк от реального человека?

Раньше можно было спокойно отличить дипфейк по различным признакам, но уже сейчас это не помогает.

- Неестественная интонация речи

- Роботизированный тон

- Неестественное моргание или движение человека на видео

- Движения губ не синхронизированы с речью

- Низкое качество звука или видео

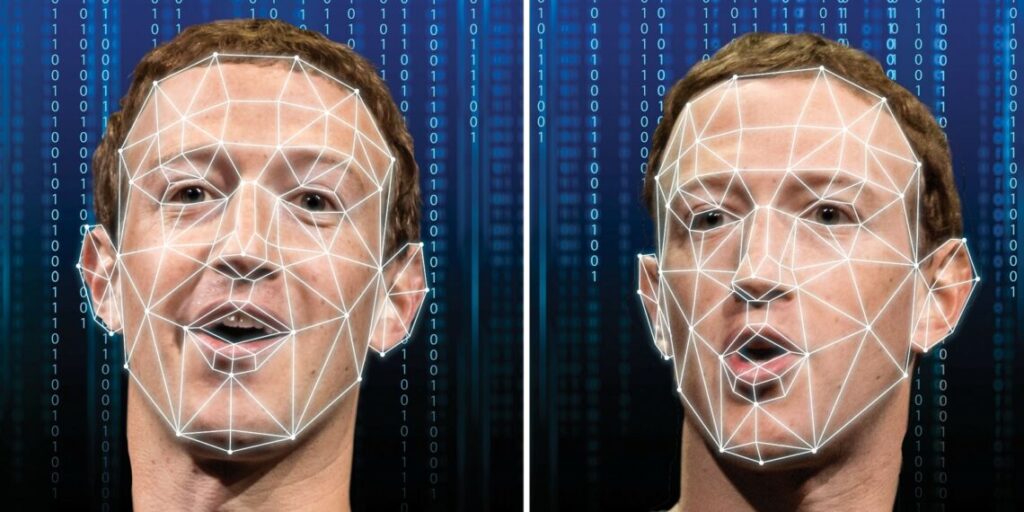

Да, но сейчас — это сложно. Противодействие дипфейкам — игра в кошки-мышки, так как мошенники тоже совершенствуют технологию. Например, в 2018 году выяснилось, что люди в дипфейках не моргают или делают это странно. Особенность сразу же учли в усовершенствованных моделях.

Чтобы стимулировать создание технологий для обнаружения дипфейков, Facebook и Microsoft проводят Deepfake Detection Challenge. В 2020 году в нем приняли участие более 2 тыс. человек. Разработчикам удалось добиться точности распознавания более 82% на стандартном тестовом датасете, но на усложненном (с отвлекающими компонентами вроде надписей) она упала чуть более чем до 65%.

ПО для обнаружения дипфейков можно обмануть, слегка видоизменяя входные данные, так что исследователи продолжают вести работу в этой области. В июне 2021 года ученые из Facebook и Университета штата Мичиган объявили о новой разработке. Обычно детекторы определяют, какая из известных моделей ИИ сгенерировала дипфейк. Новое решение лучше подойдет для практического применения: оно может распознавать подделки, созданные с помощью методов, с которыми алгоритм не сталкивался при обучении.

Еще один способ: поиск цифровых артефактов. У людей в дипфейках могут не совпадать цвета левого и правого глаза, расстояние от центра глаза до края радужной оболочки, отражение в глазах. Встречаются плохо прорисованные зубы и нереалистично темные границы носа и лица. Но в современных подделках увидеть такие артефакты может только машина. Так что самое важное в борьбе с дипфейками — быть настороже и обращать внимание на фото, видео и аудио, которые кажутся подозрительными.

Дипфейк как товар

Доступность датасетов и предобученных нейросетевых моделей, снижение стоимости вычислений и соревнование между создателями и детекторами дипфейков подгоняет рынок. Deepfake-инструменты коммодифицируются: в сети свободно распространяются программы и учебные материалы для создания подделок. Существуют простые приложения для смартфонов, которые вообще не требуют технических навыков.

Повышенный спрос на дипфейки привел к созданию компаний, которые предлагают их как продукт или услугу. Это, например, Synthesia и Rephrase.ai. В Ernst & Young дипфейки, сделанные с помощью Synthesia, уже начали использовать в клиентских презентациях и в переписке. Стартап Sonantic специализируется на озвучке видеоигр и предлагает платформу no-code для генерации голосовых клонов.

Будущее медиа с помощью ИИ

Вместе с рынком коммерческого применения дипфейков будет расти и число мошеннических операций. В сети уже есть маркетплейсы, где публикуют запросы на подделки, например порноролики с актрисами. А некоторые алгоритмы могут сгенерировать deepfake-видео на основе одного изображения или воссоздать голос человека, используя аудио длиной в несколько секунд. Из-за этого жертвой аферистов может стать практически любой пользователь интернета.

С дипфейками борются не только с помощью технологий, но и на законодательном уровне. В США и Китае появляются законы, регулирующие их использование, а в России борьбу с ними в июле 2021 года включили в одну из дорожных карт «Цифровой экономики». Регулирование в этой области будет только усиливаться.

По материалам habr. Автор xlebanёt