Нейросети научились создавать копию любой личности — филигранно подделывать голос и внешность человека. Технология с недавних пор стала доступна всем, включая мошенников. Как не стать жертвой дипфейка?

Мы сами помогаем создать свой дипфейк

Хорошее дело фейком не назовут. Технология уже успешно используется в мошеннических схемах.

В марте 2019 года генеральный директор британской энергетической компании перечислил €220 000 после телефонного разговора, в котором знакомый голос высокопоставленного партнера из Германии потребовал перевести деньги венгерскому поставщику.

В начале 2020 года управляющий банком в Гонконге также по звонку перевел $35 млн на счет в США тому, кого принял по голосу за директора компании, с которым разговаривал накануне. Расследование показало, что мошенники использовали технологию «глубокого голоса» для имитации речи директора.

В России объектами клонирования становились бизнесмены Дмитрий Мацкевич и Олег Тиньков. Видеоролики с их дипфейками использовались для рекламы несуществующих супердоходов и содержали ссылки на мошеннические сайты.

Кажется, что все это не угрожает лично вам, но что, если по видеосвязи позвонит близкий родственник (сын, дочь, брат, мать) и будет слезно просить о срочном переводе, сообщая о неминуемой опасности? Процент поверивших в такой ситуации может оказаться очень велик.

Сегодня технология подделки человека стала максимально доступной и дешевой. Также на руку мошенникам играет тот факт, что мы все больше общаемся на расстоянии — с помощью мессенджеров, звонков, соцсетей. Все, что вы выложите в Сеть, может быть использовано для создания дипфейка. И выходит, мы сами помогаем мошенникам, когда размещаем фотографии, рассказываем, с кем общаемся и где бываем. Чем больше хороших видео выложили, тем более похожей выйдет подделка.

«Многие думают: “А что плохого, если люди узнают, где я отдыхаю? А что плохого, если я буду везде делать селфи? Это же, наоборот, хорошо. Смотрите, какая я красивая. Или: смотрите, какой я успешный”. Но это означает, что кто-то может этим воспользоваться. Кто угодно может скормить ваши фотографии нейросети и создать копию. Люди должны задуматься о том, каким выглядит новый баланс приватности и публичности», — говорит Василий Буров.

По словам эксперта, сбор разнообразной биометрии может сильно усугубить ситуацию: «Если у нейросети есть хорошие снимки нашей сетчатки глаза, значит, она сумеет изобразить такую же. Если у неё много записей нашего голоса, тогда она сумеет изобразить такой же. Если у неё много наших изображений, тогда она сможет нас имитировать. А этого всего становится много, и оно бесконтрольно от нас уходит».

Возможно ли противостоять этой технологии?

Технология создания дипфейков уже не исчезнет, её нельзя запретить или технически ограничить, считает эксперт. Значит, преступления будут неизбежно совершаться.

«Нас можно начать этим шантажировать», — объясняет Василий Буров. — «Особенно в странах со специфическим уровнем толерантности. Я говорю не только про Россию, но и про Соединённые Штаты. Это пуританская страна, несмотря на имидж. И во многих местах история про какие-то интимные отношения может оказаться крайне критичной. Достаточно вспомнить Билла и Монику».

«Необязательно даже вставлять ваше лицо в порнофильм, вас могут вставить в сцену, где вы что-нибудь не то говорите или делаете. При нынешнем уровне чувствительности к этой проблеме это довольно серьёзный пример атаки на вас».

С помощью дипфейка можно будет испортить человеку так называемый социальный рейтинг, уже существующий, например, в Китае, где ведется слежка за гражданами с помощью искусственного интеллекта через камеры, работает система распознавания лиц и с помощью этого учитываются все действия человека: на улице, в магазине, где угодно. На основании собранной информации гражданину могут отказать в кредите или работе. Есть опасения, что идея социального рейтинга будет распространена за пределы Китая.

«Прямой и полной защиты от дипфейков я, честно говоря, не вижу, — говорит Василий Буров. — Понятно, что сейчас эксперты при определенных условиях могут разобраться, где подделка. Есть особенности у изображений, которые создаются нейронными сетями.

А дальше, как обычно, возникнет война пули и брони. Эксперты будут все лучше и лучше определять, где подделка. Появятся сервисы, которые будут делать это автоматически с применением тех же нейронных сетей. Одновременно будут появляться все новые и новые технологии машинного обучения, которые сделают фейки все более реалистичными».

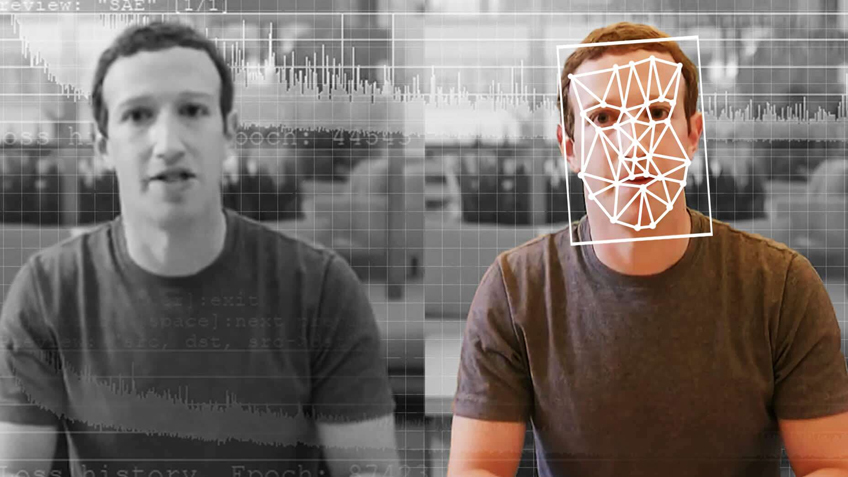

Сервисы для определения дипфейков находятся в активной разработке. Год назад компания Microsoft анонсировала сервис Microsoft Video Authenticator — программное обеспечение, которое позволяет выявить, проводились ли манипуляции с видео или фото. После того как Марк Цукерберг столкнулся с подделкой своей личности, Facebook совместно с Мичиганским университетом разработал свой «детектор» фальшивых изображений. Но большинство подобных программ отсутствуют в открытом доступе.

Впрочем, одними технологиями с киберпреступлениями не справиться, нужно менять отношение общества к этой проблеме, считает эксперт.

«В будущем, скорее всего, появится довольно высокий уровень ответственности за это, — говорит Василий Буров. — Ведь подделка личности — это такая же история, как подделка документов. И, скорее всего, подделка личности станет одним из очень серьёзных преступлений, бороться с которыми возможно путем формирования мнения об их неприемлемости. Сформируется сознание общественной нетерпимости к этому явлению, и появится другая правоприменительная практика. Я думаю, что это единственный способ взять ситуацию под контроль».

Как распознать дипфейк?

Надёжных способов отличить дипфейк от настоящего видео нет. Однако, так как технология уже не нова, то техники распознания дипфейков есть.

Раз нейронные сети применяют для создания дипфейков, то их можно использовать и для решения обратной задачи — детектирования поддельных видео. Самый распространённый подход — показать нейросети два видео: оригинальное и созданное с помощью дипфейк-технологии. Тогда нейросеть, которая учится, начнёт различать неуловимые человеком признаки сгенерированного видео.

Другой интересный подход к видео — это извлечение временных признаков между кадрами видео, так как известно, что эта согласованность не достигается при генерировании видео. То есть при просмотре видео вы не заметите, но при покадровом анализе можно увидеть недостатки. Так и обучают нейросети — обрабатывать кадры на большой скорости они могут эффективнее человека.

В теории результаты выглядят интересными, однако использовать в повседневной жизни такие разработки трудно, они требуют вычислительных ресурсов, а значит, недоступны обычным пользователям. Но благодаря тому, что этот феномен изучается, техниками анализа данных получены некоторые интересные результаты, которые могут быть полезны и простому пользователю. Ребята из Массачусетского технологического института (MIT) создали специальный сайт, где можно потренироваться. На основе своих исследований специалисты из MIT предложили ряд рекомендаций, которые могут помочь отличить дипфейк от реального видео.

- Обычно с помощью дипфейков меняют именно лицо. Оно не всегда может подходить к телу, и если это известный человек, то можно сравнить его телосложение в других источниках.

- Кожа может быть неестественно гладкой. Стоит обратить внимание на соответствие кожи возрасту человека.

- В области глаз и бровей могут быть неестественные тени, во время видео они не всегда могут передавать естественные физические изменения.

- Очки и аксессуары. На очках могут быть странные блики, а аксессуары могут быть странно сгенерированы. На фотографиях это очень заметно.

- Все ещё не всегда получается сделать волосы достаточно естественными. Могут исчезнуть или появиться бакенбарды, неестественная граница волос и кожи.

- Обращаем внимание на движение глаз: соответствуют ли они ситуации, которая происходит, и тому, чего вы ожидаете.

По материалам Наука ТВ. Авторы Евгения Шмелева и Александра Мурзина