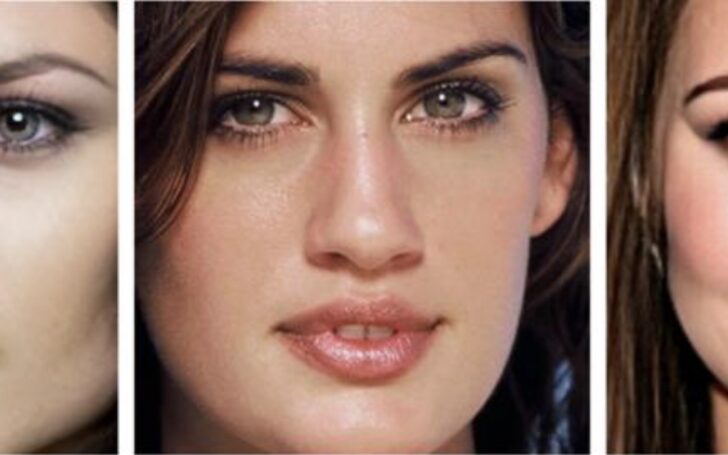

Возможно, вам пишут мошенники. Если вы уверены, что они не могли получить никаких ваших интимных фото или видео, значит, максимум, что им доступно, — использовать дипфейк, технологию, которая накладывает фото вашего лица на видео или другое изображение

Рубрика: Безопасность

Перед выборами президента США в 2020 году интернет-платформы обновили правила. Многие из них запретили публикацию deepfake-фото и видео

Использование поддельных видео- и аудиотехнологий может стать серьезной киберугрозой для бизнеса, прогнозирует специалист по кибер-аналитике CyberCube

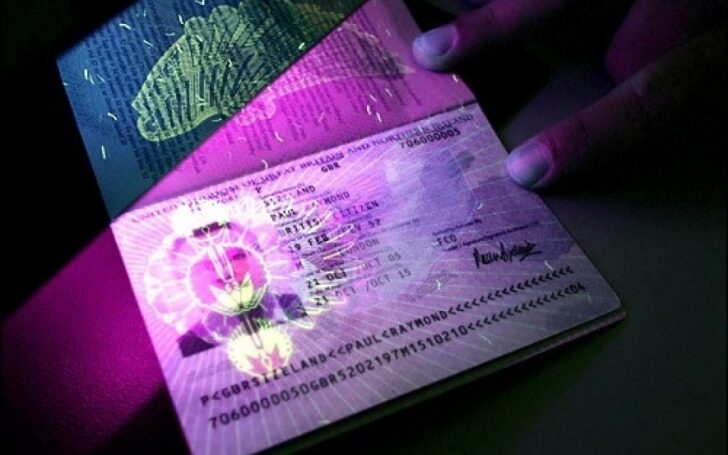

В новом отчете Secure Identity Alliance о мошенничестве с паспортами говорится о уязвимости проездных документов, даже биометрических паспортов

Mitek приобрела компанию ID R&D за 49 миллионов долларов, чтобы интегрировать ее биометрические данные по лицу и голосу, а также возможности обнаружения живости

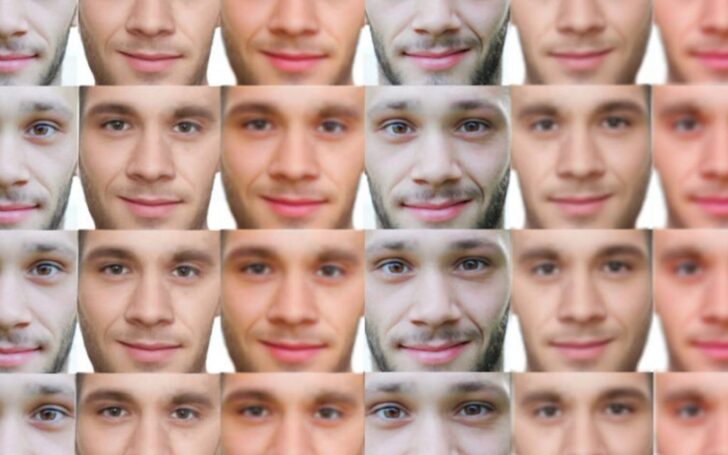

Опасная предвзятость была выявлена в наборах данных и моделях обнаружения дипфейков исследователями из Университета Южной Калифорнии

С развитием технологий взлома нам нужно доказать еще одно — «мои характеристики предъявляю я сам». Для этого используются liveness detection

Популярность голосовых сообщений набирает обороты — об аналоге Clubhouse задумался Facebook, а Telegram в последнем обновлении мессенджера добавил аудиочаты

Эту технологию уже применяют в конструктивных целях, например, в образовательных, или в киноиндустрии с её помощью «оживляют» исторических персонажей. Но, можно ли распознать дипфейк на видео?

Люди верят тому, что видят, когда выполняются следующие: это им знакомо и часто повторяется, это соответствует их взглядам, они доверяют источнику информации

Учёные Корейского ведущего научно-технологического института (KAIST) разработали первое в Южной Корее мобильное приложение, обнаруживающее фотографии или видео, которые были созданы с помощью deepfake алгоритмов.

Детекторы дипфейков не всегда справляются с выявлением подделок. Если дипфейки первого поколения выявляются с вероятностью 100%, то в случае второго поколения диапазон ошибки составляет от 15 до 30%

При анализе цифрового фотоснимка изображение разбивается для анализа на маленькие квадраты, а видео разделяется на кадры, и в каждом кадре анализируются локальные области на предмет наличия искажений

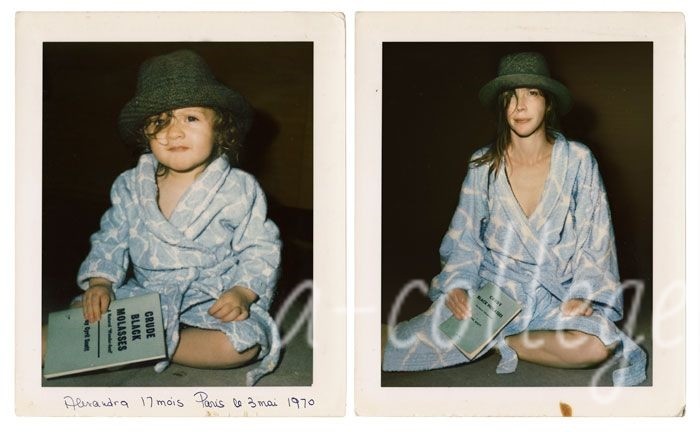

Не исключено, что в будущем эта разработка будет использована в онлайн-сервисах различных исторических организаций, в музеях или политическими партиями для оживления известных фигур. С одной стороны это повысит интерес к истории, но создание исторически не подтверждённых подделок пугает возможностью «документального» подтверждения для изменения исторической правды

В официальном документе, опубликованном фирмой Nisos, специализирующейся в области кибербезопасности, описываются пять инцидентов, связанных с deepfake аудио-атаками

В затруднение распознавания людей в масках есть и положительная сторона. Проблему, с которой сталкиваются сервисы аутентификации, предстоит решить программам распознавания лиц

«Не разговаривайте с незнакомцами», — посоветовали нам родители. В эпоху двойной жизни: реальной и виртуальной:« Не раскрывайте все в Facebook»!

Дмитрий Мацкевич известный в России предприниматель, и вряд ли станет связываться с мошенниками. Вероятно, эти видео были созданы мошенниками при помощи deepfake. Держитесь подальше от тех, кто предлагает быстрые заработки. Если кто-то знает, как можно ежегодно увеличивать своё состояние на 360%, то он должен хранить этот секрет в тайне, а не обесценивать его, привлекая сотни новых конкурентов

AI все чаще присутствует в нашей повседневной жизни. Технологические компании используют огромное количество данных, доступных им, чтобы сделать более точные прогнозы, отследить наши запросы и предложить новые услуги. Поскольку AI уже используется во всем мире, возникает вопрос, кто несет ответственность за решения, принимаемые им?

У людей в мозгу есть функция стереотипов. Это полезная функция, поскольку не может каждый обыватель знать про две сотни вирусов

Если сервисы будут полагаться на использование голосовых команд по телефону, то мошенники смогут использовать полученные образцы для синтеза вашего голоса и последующей атаки на такие сервисы. Кстати, нейросетей, способных по сэмплам смоделировать голос, уже достаточно

Дон Фостер (Don Foster), вице-президент по глобальным продажам Commvault, считает, что «Технологии Deep Fake простимулируют рост рынка решений для тестирования целостности и верификации данных»

В 2020 году появилось несколько новых способов обмана с использование сгенерированных данных. Для этого мошенники подделывают как голоса, так и манеру речи

Ещё вчера все говорили про опасность алгоритмов, генерирующих поддельные изображения и голос. Обсуждалась возможность использования этих алгоритмов в конструктивных целях. Но такие алгоритмы уже вчерашний день. 2021 год ознаменуется появлением более опасных алгоритмов: алгоритмов, которые понимают причину тех или иных действий и подстраиваются под наше психологическое восприятие. Социальная инженерия автоматизируется и ставится на поток

Большая часть компаний по развитию технологий дипфейков сосредоточена в США и Китае. В России – Dowell (входит в Everypixel Group), AvaTunes и Vera voice