Десятки стартапов используют генеративный ИИ, чтобы делать ярких и счастливых виртуальных людей для развлечения и получения прибыли. Большие языковые модели, такие как GPT, добавляют новое сложное измерение.

В статье использован материал Алекса Пастернака, опубликованной на fastcompany.com, + добавлено несколько видео и ссылок.

Раньше, если вы хотели создать убедительный диалог для дипфейкового видео , вам приходилось писать слова самостоятельно. В наши дни проще, чем когда-либо, позволить ИИ сделать всё за вас.

«Теперь вам просто нужно иметь представление о контенте», — говорит Натали Монбиот, руководитель отдела стратегии Hour One, стартапа из Тель-Авива, который привносит технологию дипфейков в обучающие онлайн-видео, бизнес-презентации, новостные репортажи и рекламу. В прошлом месяце компания добавила новую функцию, включающую GPT от OpenAI; теперь пользователям нужно только выбрать из десятков аватаров и голосов, созданных актёрами, и ввести подсказку, чтобы получить реалистичную говорящую голову. (Как и некоторые из его конкурентов, Hour One также позволяет пользователям оцифровывать свои лица и голоса.)

Это одна из многих компаний, занимающихся «виртуальными людьми», которые добавили языковые инструменты, на основе искусственного интеллекта, к своим платформам, чтобы расширить охват своих аватаров и получить новые возможности мимикрии. В настоящее время более 150 компаний создают продукты на основе генеративного ИИ — универсального термина для систем, которые используют неконтролируемое обучение для создания текста и мультимедиа — для создателей контента, маркетологов и медиакомпаний.

Технология дипфейков всё чаще появляется и в Голливуде. ИИ позволяет Энди Уорхолу и Энтони Бордейну говорить из загробного мира, обещает навсегда сохранить молодость Тома Хэнкса и позволяет нам наблюдать, как Ким Кардашьян, Джей Зи и Грета Тунберг ссорятся, из-за ухода за садом, в бессмысленной британской телевизионной комедии.

Такие стартапы, как Hour One, Synthesia, Uneeq и D-ID, видят более прозаические приложения для этой технологии: размещение бесконечного количества сияющих, счастливых людей в персонализированной онлайн-рекламе, видеоуроках и презентациях. Виртуальные люди, созданные Hour One, уже размещают видео для транснациональных корпораций здравоохранения и обучающих компаний, а также публикуют обновления новостей для криптовалютного веб-сайта и футбольные репортажи для немецкой телевизионной сети. Индустрия представляет себе Интернет, который всё больше адаптируется к нам и отражает нас, метавселенную, где мы будем взаимодействовать с фальшивыми людьми и создавать цифровых двойников, которые могут, например, посещать собрания вместо нас, когда нам не хочется выступать перед камерой.

Подобные идеи вызвали новую золотую лихорадку в области генеративного ИИ. Платформа для создания изображений Stability AI и текстовый редактор Jasper, например, недавно привлекли 101 и 125 миллионов долларов соответственно. В прошлом году Hour One привлекла 20 миллионов долларов от инвесторов и увеличила свой штат с дюжины до пятидесяти человек. Sequoia говорит, что индустрия генеративного ИИ будет генерировать триллионы, в стоимостном выражении.

«Это действительно похоже на поворотный момент в технологии»

Говорит Монбиот

Но растут опасения, что в сочетании, эти имитационные инструменты могут также стимулировать работу мошенников и пропагандистов, помогая демагогам, разрушать рынки и подрывать и без того хрупкое социальное доверие.

«Риск, связанный с объединением дипфейков, виртуального аватара и автоматической генерации речи, возрастает»

Говорит Сэм Грегори, программный директор Witness, правозащитной группы, специализирующейся на дипфейках

В прошлом месяце организация NewsGuard, занимающаяся наблюдением за дезинформацией, предупредила об опасностях GPT, заявив, что она даёт торговцам политической дезинформацией, авторитарным информационным операциям и мистификациям в области здравоохранения эквивалент «армии опытных писателей, распространяющих ложные нарративы».

Для создателей дипфейковых видео и аудио GPT, может использоваться для создания более реалистичных версий известных политических и культурных деятелей, способных говорить так, чтобы лучше имитировать этих людей. Его также можно использовать для более быстрого и дешёвого создания армии людей, которых не существует, фальшивых актёров, способных свободно передавать сообщения на нескольких языках.

Это делает их полезными, говорит Грегори, для стратегии дезинформации, от «обманчивой коммерческой персонализации до лолз-стратегий шитпостинга в больших масштабах».

В прошлом месяце в WhatsApp появилась серия видеороликов, в которых несколько фальшивых людей, с американским акцентом, неуклюже высказывались в поддержку военного переворота в Буркина-Фасо. Охранная фирма Graphika заявила на прошлой неделе, что те же самые виртуальные люди были задействованы в прошлом году в рамках прокитайской операции влияния.

https://twitter.com/LaurenBinDC/statuses/1618410771532386306

Но аудиовизуальный ИИ быстро «обучается», а инструменты, подобные GPT, только усиливают мощь таких видео, позволяя лжецам быстрее и дешевле создавать более плавные и убедительные дипфейки.

Комбинация языковых моделей, распознавания лиц и программного обеспечения для синтеза голоса «сделает контроль над своим внешним видом пережитком прошлого», предупредила базирующаяся в США Eurasia Group в своём недавнем ежегодном отчёте о рисках, опубликованном в прошлом месяце. Геополитические аналитики оценили дезинформацию с помощью ИИ как третий по величине глобальный риск в 2023 году.

«Большие языковые модели, такие как GPT-3 и готовящаяся к выпуску GPT-4, смогут надёжно пройти тест Тьюринга — Рубикон способности машин имитировать человеческий интеллект», — говорится в отчете. «Этот год станет переломным моментом для роли прорывных технологий в обществе».

Брэнди Ноннеке, содиректор Центра права и технологий Беркли, говорит, что для высококачественной дезинформации сочетание больших языковых моделей, таких как GPT, с генеративным видео — это «пороховая бочка».

«Технологии видео и аудио дипфейков совершенствуются с каждым днём», — говорит она. «Объедините это с убедительным сценарием, созданным ChatGPT, и это только вопрос времени, когда дипфейки станут подлинными».

DEEPERFAKES

Термин дипфейки, в отличие от названий других недавних прорывных технологий (искусственный интеллект, квант, синтез), всегда предполагал нечто головокружительно жуткое. И с момента своего жуткого происхождения, когда в 2017 году пользователь Reddit под ником «deepfakes» начал публиковать поддельные порновидео со знаменитостями, технология быстро превратилась в преступную жизнь. Его использовали, чтобы «раздеть» бесчисленное количество женщин, украсть десятки миллионов , привлечь таких людей, как Илон Маск и Джо Роган, к мошенничеству с криптовалютой, заставить знаменитостей говорить ужасные вещи, нападать на активистов движения за права палестинцев и обманывать Европейских политиков, думающих, что они разговаривают по видеосвязи с мэром Киева. Многие обеспокоены тем, что программное обеспечение будет использоваться не по назначению для проверки улик, таких как нательные камеры и видеонаблюдение, а Министерство внутренней безопасности предупредило о его использовании не только для запугивания и шантажа, но и в качестве средства манипулирования акциями и сеяния политической нестабильности.

В течение многих лет все негативные истории удерживали клиентов и инвесторов от дипфейков. Но после периода, который, по словам Монбиота, был отмечен «нагнетанием паники» в СМИ, в технологии произошёл поворот к более широкому признанию, «от реальных попыток убедить людей или просто отвлечь их внимание».

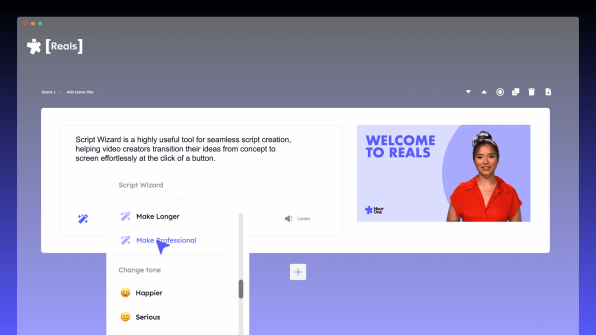

В последнее время, по её словам, собственная исполнительная команда Hour One составляет еженедельные отчёты, используя своих собственных персонализированных «виртуальных двойников», иногда с помощью инструмента «Мастер сценариев». Они также тестируют способы адаптации GPT, например, обучая его разговорам в Slack. (В декабре Google и DeepMind представили клинически ориентированный LLM под названием Med-PaLM7, который, по их словам, может ответить на некоторые медицинские вопросы почти так же, как и обычный врач-человек.) По мере того, как технология становится быстрее и дешевле, Hour One также надеется размещать аватары в видеозвонки в реальном времени, предоставляя пользователям свои собственные «суперкоммуникаторы», улучшенные «расширения» самих себя.

«Мы уже делаем это каждый день. И это почти как ваша анимированная версия, которая на самом деле может сделать гораздо больше, чем красивая фотография. Он действительно может работать от вашего имени»

Говорит она в социальных сетях

Но, пожалуйста, говорит Монбиот, не называйте их дипфейками.

«Мы отличаемся от [дипфейков], потому что определяем «дипфейки» как несанкционированные», — говорит она. Компания лицензировала изображения сотен актёров, чьи головы, преобразованные с помощью ИИ, появляются только в видеороликах, которые соответствуют её договорным соглашениям и пользовательским условиям обслуживания: «Ни в коем случае незаконный, неэтичный, вызывающий разногласия, религиозный, политический или сексуальный контент», — говорит юридический, мелкий шрифт. Для известных личностей, использование ограничено «личным одобренным использованием». Компания также размещает водяной знак «AV» внизу своих видео, что означает «Измененные визуальные эффекты».

Сами люди выглядят и звучат очень реалистично — в некоторых случаях даже слишком реально, слегка застряв на дальнем краю зловещей долины. По словам Монбиота, это ощущение гиперреальности также является преднамеренным, и это ещё один способ «провести различие между реальным вами и вашим виртуальным близнецом».

Но GPT может размыть эти границы. После регистрации бесплатной учётной записи, которая включает в себя несколько минут видео, я начал с того, что попросил Script Wizard, инструмент Hour One на основе GPT, подробно рассказать о рисках, которые представляет Script Wizard. Машина предупредила о «утечке данных, нарушении конфиденциальности и манипулировании контентом» и предложила «чтобы свести к минимуму эти риски, вы должны обеспечить принятие мер безопасности, таких как регулярные обновления программного обеспечения и систем, используемых для Script Wizard». Кроме того, вы должны помнить о том, кто получает доступ к технологии и что с ней делается».

Наряду с собственными договорными соглашениями со своими субъектами и пользователями, Hour One также должна соблюдать условия обслуживания OpenAI, которые запрещают использование её технологии для пропаганды нечестности, обмана или манипулирования пользователями или попытки повлиять на политику. Monbiot говорит, что для обеспечения соблюдения этих условий компания использует «комбинацию инструментов и методов обнаружения, для выявления любого злоупотребления системой» и «навсегда блокирует пользователей, если они нарушают наши условия использования».

Но учитывая, как сложно группам людей или машин обнаружить политическую дезинформацию, вероятно, не всегда будет возможно выявить злоупотребление. (Synthesia, которая использовалась для производства прокитайских пропагандистских видео, также запрещает политический контент.) И ещё сложнее остановить злоупотребление, после того, как видео было снято.

«Мы понимаем, что злоумышленники будут стремиться обмануть эти меры, и это будет постоянной проблемой по мере развития контента, создаваемого ИИ»

Говорит Монбиот

КАК СДЕЛАТЬ ДИПФЕЙК НА ОСНОВЕ GPT

Создать дипфейк, который произносит текст, написанный искусственным интеллектом, так же просто, как сгенерировать сценарии от первого лица с помощью ChatGPT и вставить их в любую платформу виртуальных людей. (На своём веб-сайте Synthesia предлагает несколько руководств о том, как это сделать). Кроме того, создатель дипфейков может загрузить DeepFace, программное обеспечение с открытым исходным кодом, популярное среди неконсенсуального порносообщества, и создать свой собственный цифровой аватар, используя голос такой компании, как ElevenLabs или Resemble AI. (ElevenLabs недавно прекратила предлагать бесплатные пробные версии после того, как пользователи 4Chan злоупотребили платформой, в том числе заставив голос Эммы Уотсон прочитать часть Mein Kampf; Resemble сама экспериментировала с GPT-3 ). Один кодер недавно использовал ChatGPT, нейронную систему преобразования текста в речь Microsoft Azure и другие системы машинного обучения, для создания виртуальной «жены», в стиле аниме, которая будет учить его китайскому языку.

Но на платформах самообслуживания, таких как D-ID или Hour One, интеграция GPT делает процесс ещё проще, с возможностью настройки тона и без необходимости регистрироваться на OpenAI или других платформах. В процессе регистрации Hour One у пользователей запрашивается их имя, адрес электронной почты и номер телефона; D-ID хочет только имя и адрес электронной почты.

После подписки на бесплатную пробную версию в Hour One, потребовалось ещё несколько минут, чтобы сделать видео. Я вставил первую строчку из пресс-релиза Hour One и позволил Мастеру сценариев дописать остальную часть текста, создав более весёлый сценарий, чем я себе представлял (хотя я выбрал тон «Профессиональный»). Затем я предложил ему описать некоторые «риски» объединения GPT с дипфейками, и он предложил несколько опасностей, включая «манипулирование контентом». (Система также предложила свою собственную манипуляцию, когда назвала GPT-3 «самой мощной технологией искусственного интеллекта, доступной сегодня».)

После нескольких попыток мне также удалось заставить инструмент GPT включить несколько предложений, аргументирующих «один конфликт» — кажущееся нарушение условий предоставления услуг, запрещающих политический контент.

В результате видео, размещённое, с говорящей головой, в фотореалистичных условиях студии, экспортировалось за несколько минут. Единственным явным признаком того, что человек был синтетическим, была маленькая отметка «AV», которая находилась внизу видео, и которую, если бы я захотел, я мог бы легко отредактировать.

Исследователи предупреждают, что даже без синтетического видео такие приложения, как ChatGPT, могут быть использованы для нанесения всевозможного ущерба нашему информационному ландшафту, от создания фальшивых новостей с нуля, до простого усиления сообщений уже влиятельных лоббистов. Рене ДиРеста, менеджер по техническим исследованиям Стэнфордской интернет-обсерватории, больше всего беспокоит то, что GPT означает просто для текстовой дезинформации , которую «будет легко генерировать в больших объёмах и с меньшим количеством теллсов для обнаружения», чем существующие с другими виды синтетических сред. Венкеташ Рао утверждает, что для того, чтобы обмануть людей, заставив их думать, что вы тоже человек, убедительное лицо и голос могут вообще не понадобиться. «Текст — это всё, что вам нужно».

Синтетических людей должно быть легче обнаружить, чем синтетический текст, потому что они предлагают больше «подсказок». Но виртуальные люди, особенно те, у кого есть предложения, написанные искусственным интеллектом, будут становиться всё более убедительными. Исследователи работают над ИИ, который сочетает в себе большие языковые модели с воплощённым восприятием, создавая разумные аватары, ботов, которые могут учиться с помощью нескольких модальностей и взаимодействовать с реальным миром.

Последняя версия GPT уже способна пройти своеобразный тест Тьюринга у технарей и журналистов, убедив их в том, что у неё есть свои, порой довольно жуткие, личности. (Вы могли видеть в навыках мимикрии языковых моделей, своего рода зеркальный тест для нас, который мы, по-видимому провалили.) Эрик Хорвиц, главный научный сотрудник компании Microsoft, которая имеет большую долю в OpenAI, в прошлом году, в своей статье беспокоился об автоматизированных интерактивных дипфейках, способных вести беседу в реальном времени. Независимо от того, будем ли мы знать, что разговариваем с подделкой или нет, предупреждал он, такая способность может привести в действие убедительные и настойчивые кампании влияния: «Нетрудно представить, как объяснительная сила специально подобранных синтетических историй, может превзойти, в конкурентной борьбе, объяснительную силу правдивых нарративов».

Несмотря на то, что системы ИИ продолжают совершенствоваться, они не могут избежать собственных ошибок и проблем с «личностью» . Большие языковые модели, такие как GPT, работают, сопоставляя слова на миллиардах страниц текста в Интернете, а затем реконструируя предложения в статистически вероятные аппроксимации того, как люди пишут. Результатом является имитация мышления, которое звучит правильно, но также может содержать тонкие ошибки. OpenAI предупреждает пользователей, что, помимо фактических ошибок, ChatGPT «иногда может давать вредные инструкции или предвзятый контент».

Со временем, по мере того как сам этот производный текст распространяется в сети, содержащий слои ошибок, допущенных машинами (и людьми), он становится новым учебным материалом для следующих версий модели письма ИИ. По мере того, как мировые знания подвергаются воздействию ИИ, они сжимаются и расширяются снова и снова, подобно размытому снимку в формате jpeg. Как написал в The New Yorker писатель Тед Чанг: «Чем больше в Интернете публикуется текста, сгенерированного большой языковой моделью, тем более размытой становится информация в интернет-пространстве».

Для тех, кто ищет достоверную информацию, написанный ИИ текст может быть опасен. Но если вы пытаетесь запутать зону, возможно, это не так уж и плохо. Учёный-компьютерщик Гэри Маркус отметил, что для пропагандистов, наводняющих зону, чтобы сеять путаницу, «галлюцинации и случайная ненадёжность больших языковых моделей являются не препятствием, а достоинством».

БОРЬБА С ДИПФЕЙКАМИ

По мере того, как золотая лихорадка ИИ продвигается вперёд, глобальные усилия по повышению безопасности технологии изо всех сил пытаются наверстать упущенное. Китайское правительство приняло первый значительный набор правил в январе, требуя от поставщиков синтетических людей давать реальным людям возможность «опровергать слухи» и требуя, чтобы изменённые носители содержали водяные знаки и согласие субъекта. Правила также запрещают распространение «фейковых новостей», которые считаются подрывными для экономики или национальной безопасности, и дают властям широкую свободу толкования того, что это означает. (Правила не распространяются на дипфейки, сделанные гражданами Китая за пределами страны).

Также растет стремление к созданию инструментов, помогающих обнаруживать искусственных людей и медиа. Коалиция за происхождение и подлинность контента, группа, возглавляемая Adobe, Microsoft, Intel, BBC и другими, разработала стандарт водяных знаков для проверки изображений. Но без широкого распространения протокол, скорее всего, будет использоваться только теми, кто пытается доказать свою честность.

Эти усилия будут лишь эхом роста многомиллиардной индустрии, занимающейся созданием реалистичных фальшивых людей и превращением их в совершенно нормальных, даже крутых.

По словам Грегори из Witness, этот переход, к широкому признанию виртуальных людей, сделает ещё более насущной необходимость сигнализировать о том, что является фальшивкой.

«Чем больше мы привыкнем к синтетическим людям, тем больше вероятность того, что мы примем синтетического человека как неотъемлемую часть, например, новостной передачи. Вот почему инициативы, связанные с ответственными синтетическими медиа, должны делать акцент на телеграфировании роли ИИ в тех местах, где вы должны категорически ожидать, что манипуляции не происходят или всегда сигнализируются (например, выпуски новостей)»

Говорит он

На данный момент, отсутствие стандартов и модерации, может оставить работу по контролю, за этими видео, алгоритмам таких платформ, как YouTube и Twitter, которые изо всех сил пытались обнаружить дезинформацию и ядовитую речь в обычных видео, не созданных искусственным интеллектом. А дальше дело за нами, нашими способностями к проницательности и человеческому разуму, хотя неясно, как долго мы можем им доверять.

Монбиот, со своей стороны, говорит, что перед ожидаемыми усилиями, по регулированию технологии, индустрия всё ещё ищет лучшие способы указать, что является подделкой.

«Создание этого различия там, где это важно, я думаю, будет иметь решающее значение в будущем. Особенно, если становится всё проще и проще, просто создать аватар или виртуального человека, только на основе небольшого количества данных, я думаю, что наличие систем, основанных на разрешениях, имеет решающее значение»

Говорит она

«Потому что иначе мы просто не сможем доверять тому, что видим».

По материалам vc