Просмотр с дипфейками знаменитых людей, которые не имели к этому отношения, является «разрушением человеческой сущности, человеческих и семейных отношений»

Рубрика: Безопасность

Deepfake меняет представление о возможностях видеосвязи, но для её положительного воздействие, необходимо участие всех заинтересованных сторон

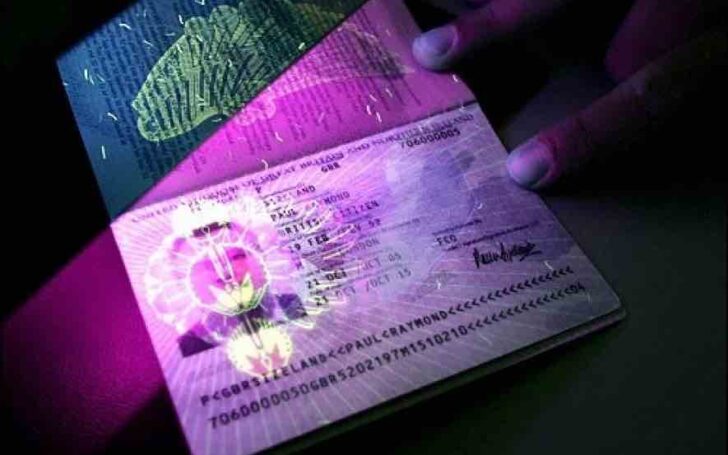

В Google Play удалённое приложение имело возрастной рейтинг «E» (для всех возрастов) и насчитывало более 10 000 загрузок и более 200 отзывов

Изучение и предотвращение атак с использованием голосовых дипфейков является важной задачей для обеспечения безопасности в цифровой среде

Компаниям никогда не следует загружать и исполнять код, который они не понимают и не проверяли – например, репозитории GitHub с открытым исходным кодом

В киберпространстве разгорается скандал, связанный с использованием генеративного ИИ для создания порнографических картинок без согласия изображённых на них лиц

Инструменты искусственного интеллекта применяются для обзвона и выявления потенциальных жертв, что позволяет мошенникам быть эффективнее

Искусственный интеллект станет постоянным элементом нашей жизни, и дискуссия об этичном использовании генеративного ИИ будет становиться всё острее

В условиях развития дипфейков, а также активной интеграции этого инструмента в противоправную деятельность опасения закономерны, отметил Антон Немкин

Специфика технологии заключается в выборе ярлыка, который описывает то, что на самом деле изображено, чтобы размыть границы этого понятия

Современные мошенники всё чаще используют популярные мессенджеры, такие как Telegram и WhatsApp, для реализации своих злонамеренных схем

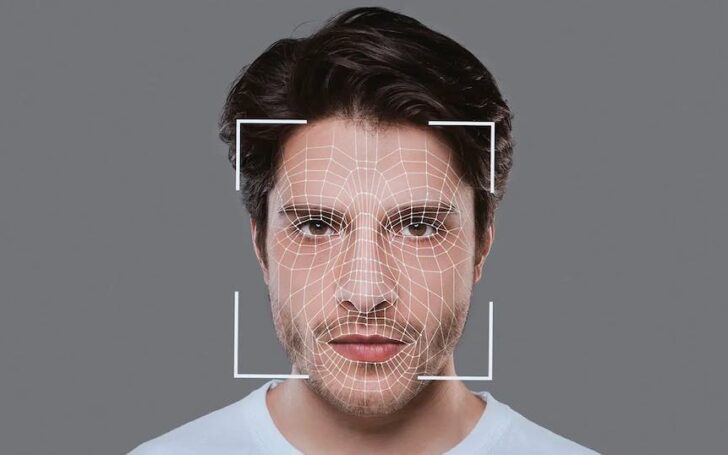

В настоящее время дипфейки выявляют вручную криминалисты и специалисты по информационной безопасности при анализе конкретного видео

С развитием технологий, проникающих в нашу повседневную жизнь, увеличивается число мошеннических схем с использованием популярных мессенджеров

Мошенники воспользовались deepfake-технологией замены лиц и голосов. В ходе видеоконференции они выдали себя за руководство головного офиса

«Когда менять голос смогут в режиме онлайн, у всех нас будут огромные проблемы»

Владислав Тушканов, эксперт «Лаборатории Касперского»

Выводы доклада были сделаны на основе дискуссии на тему «Глубокие подделки и демократия», проведённой MediaNama 17 января при поддержке Meta и Google

Многие мечтали о летающих машинках и космических приключениях, но вместо этого мы столкнулись с новыми схемами мошенничества, использующими нейросети и дипфейки

Человек, незнакомый глубоко с новейшими технологиями, справедливо задаст вопрос: «Как это может использоваться?». Попробуем дать ответ…

Onfido сообщает об огромном всплеске глубоких фейковых атак, поскольку правительства борются с новыми потенциальными угрозами

Граждане республики также называют детей в честь казахстанских городов. В стране живут 24 Астаны, 20 Алма-Аты и 3 Шымкента

Глубокие подделки потенциально могут нанести значительный вред, распространяя дезинформацию, манипулируя общественным мнением и подрывая доверие

В России дипфейки пока экзотика, но уже сейчас люди и целые компании теряют деньги из-за мошенников, использующих эту технологию. Можно ли себя обезопасить?

Согласно отчету биометрической компании iProov, мошенники все чаще используют инструменты искусственного интеллекта для создания поддельных изображений и видео

Мошенники применяют разные схемы, чтобы обмануть. Одна из них, когда сотруднику звонит якобы его руководитель и просит срочно сделать перевод или оплатить счет

Группа из 20 ведущих технологических компаний объявила о совместном обязательстве бороться с дезинформацией, полученной с помощью искусственного интеллекта