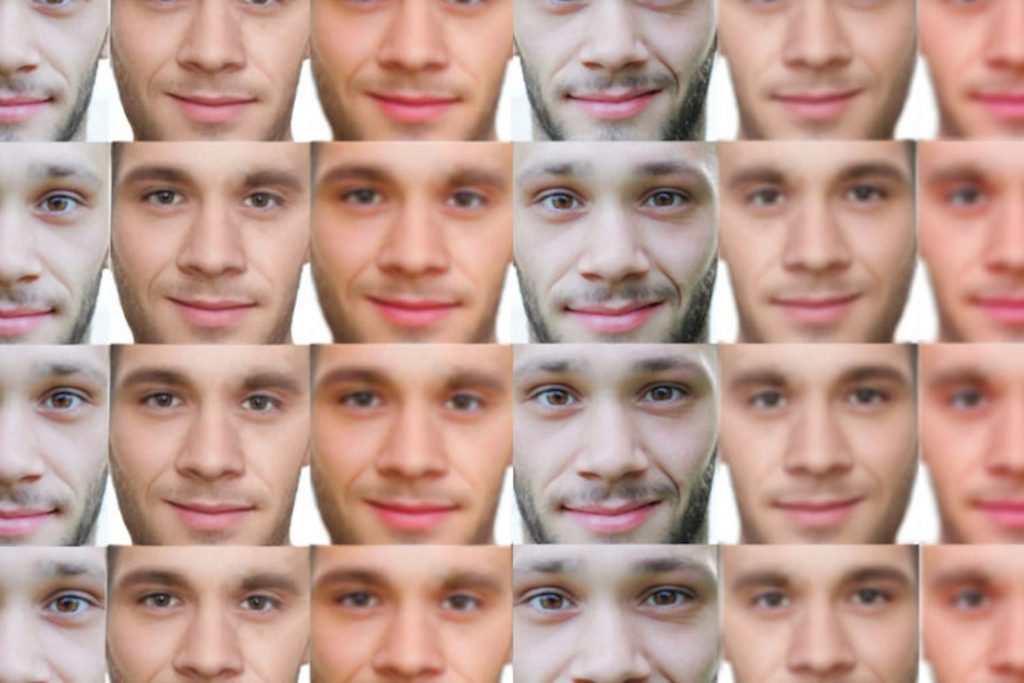

Сообщается о двух случаях, связанных с попытками помешать мошенничеству deepfake с видео и аудио. В статье открытого доступа, опубликованной SPIE, международной профессиональной ассоциацией оптики и фотоники, сообщается о новом алгоритме, который, как сообщается, набрал точность определения глубинного поддельного видео в 99,62%. По некоторым сообщениям он был точным в 98,21% случаев.

Прошло три года с тех пор, как угроза глубоких подделок широко распространилась в глобальных средствах массовой информации, и за это время их реализации стали более изощренными.

Страх перед неправильным использованием (помимо простых замен лиц порно-актеров на лица знаменитостей) вызывал шок, а некоторые наблюдатели предупреждают, что подчиненные ключевого военачальника страны, обладающей ядерным оружием, могут поверить в экстренно отданный приказ о запуске ракет.

Авторы статьи, два из Института инженеров и технологий им. Тапара и третий из Института информационных технологий Индрапрастха (оба в Индии), утверждают, что это важный этап исследований.

Они утверждают, что первыми сделали общедоступной базу данных о фальшивых подделках, которыми манипулируют генерирующие состязательные сети, в которых фигурируют известные политики. Их база данных состоит из 100 исходных и 100 целевых видео.

Более того, они утверждают, что являются первыми разработчиками алгоритма, который может обнаружить глубокие фальшивки политиков в течение двух секунд с начала клипа. Команда сказала, что они использовали временные последовательности кадров, взятые из клипов, чтобы выявить подмену.

Поставщики биометрии ID R&D и NtechLab заняли лидирующие позиции в недавнем конкурсе Deepfake Detection Challenge.

Усилия по обнаружению голосового мошенничества также развивается быстрыми темпами.

Когда люди всех слоев общества стали регулярно участвовать в видеозвонках, в среднесрочной перспективе звуковая deepfake атака стала выглядеть более угрожающей.

Сравнивая эти две угрозы, казалось более вероятным, что убедительный фальшивый звонок может заставить ключевого сотрудника среднего звена помочь боссу в чрезвычайной ситуации.

В официальном документе, опубликованном фирмой Nisos, специализирующейся в области кибербезопасности, описываются пять инцидентов, связанных с deepfake аудио-атаками.

Nisos пишет в маркетинговом документе, что она фактически расследовала одну такую атаку — включая оригинальный синтетический звук. Это был фальшивый голос генерального директора компании, «просившего сотрудника перезвонить, чтобы «завершить» срочную коммерческую сделку».

Сотрудник, благоразумно, сразу позвонил в юридический отдел. Номер, по которому потенциальная жертва должна была позвонить, был записан с помощью VOIP-сервиса.

Инженеры Nisos изучили запись с помощью Spectrum3d, инструмента спектрограммы, который наряду с простым прослушиванием сообщения и сравнением его с известным человеческим голосом выявил некоторые данные.

В конечном счете, лучший совет, который Nisos или кто-либо другой в отрасли может предложить, это сохранять здравый смысл. Если что-то о звонке вызывает подозрение, позвоните в юридический отдел.

По материалам Biometrics Research Group. Автор Jim Nash