Все поддельные видео, оказывается, обладают характерной особенностью, которая свидетельствует о том, что они поддельные

Индустрия подделок достигла небывалых высот. Пример тому рекламные ролики, в которых «снимаются» Брюс Уиллис и Азамат Мусагалиев. Не исключено, что Азамат настоящий, но Брюс Уиллис точно поддельный. Хотя и выглядит, как живой.

«Чудеса» подобного рода стали возможными благодаря искусственному интеллекту и технологии deep fake. Поддельные персонажи генерирует GAN – нейронная самообучающаяся сеть. Она же генеративно-состязательная (Generative adversarial network). Сеть изучает реальные изображения людей и создает свои – другие, что называется, по образу и подобию. Получившиеся творения уходят в родственную сеть, которая определяет, насколько они реалистичны. И если находит изъяны, то возвращает на доработку. Процесс продолжается до тех пор, пока сети не «договорятся» и не решат, что фейк удался.

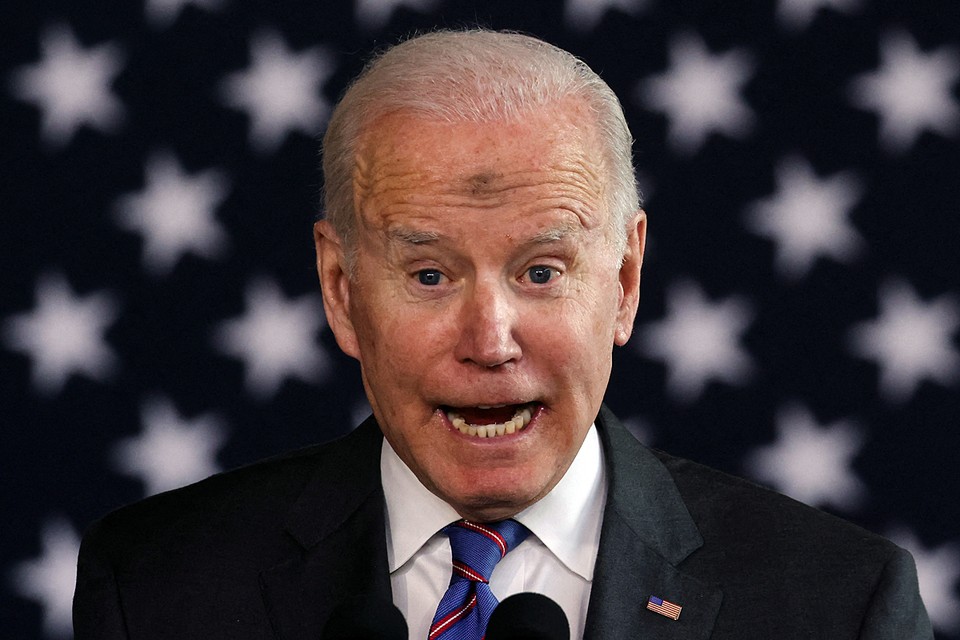

От deep fake-роликов, изготовленных для рекламы товаров и услуг, никакого вреда, конечно, нет. Нравится – смотрите. Но в последнее время GAN-продукцию стали использовать злоумышленники для производства фейковых «новостных сюжетов». Их демонстрируют в соцсетях, на сайтах СМИ, да и по некоторым официальным телеканалам, иллюстрируя несуществующие ужасы спецоперации на Украине. Дело легко может дойти до того, что по телевизору начнут «выступать» руководители тех или иных стран с откровенной deep fake-ахинеей. И поди разберись, в самом ли деле они свихнулись. Или их подставил искусственный интеллект.

Обман уже так разросся, что 4 марта 2022 года Госдума приняла закон, вводящий уголовное наказание и крупные штрафы за фейки, которые дискредитируют российскую армию и призывают к санкциям против России.

Специалисты, конечно, докопаются, где правда, а где наглая ложь. А обычные люди? Смогут ли они понять, что их дурят?

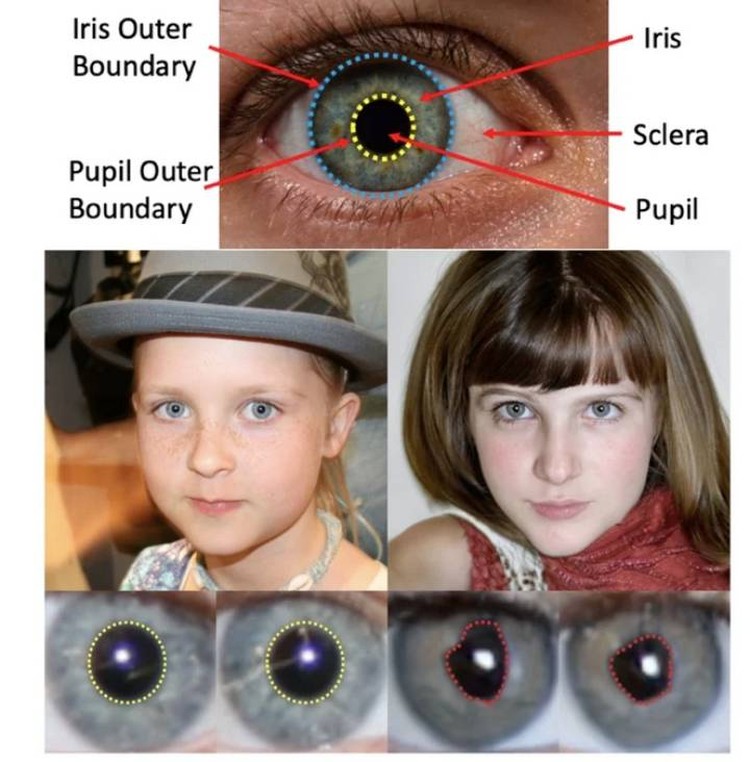

– Смогут. Не все, но более-менее продвинутые пользователи разберутся, – ещё в сентябре прошлого года обнадёжили китайские компьютерщики, работающие в Нью-Йоркском университете (State University of New York). Под руководством Хуи Гуо (Hui Guo) они проанализировали тысячу deep fake-роликов. И во всех нашли характерный изъян: поддельных людей выдавали глаза. Конкретно – зрачки. У настоящих людей они круглые, у поддельных – нет. Поддельные зрачки неправильной формы. Почему так получается, никто толком не знает, но факт, что называется, налицо. Гуо уверяет, что этот изъян технологии GAN становится хорошо заметен при увеличении изображения.

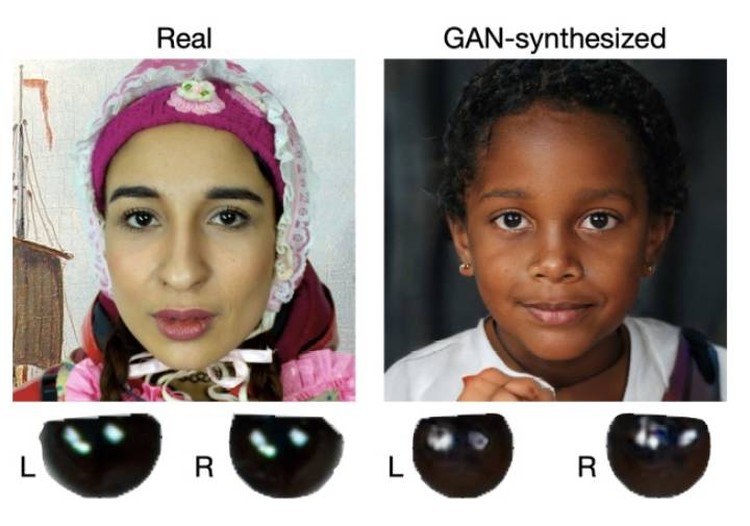

Кстати, два года назад отличились другие китайцы – из Университета Баффало (Computer Science and Engineering University at Buffalo). Под руководством Сивея Лю (Siwei Lyu) они первыми обнаружили, что GAN-сгенерированные изображения несовершенны. И что изъян кроется опять же в глазах.

Компьютерщики группы Лю разглядели, что настоящие глаза отличаются от поддельных отражениями, которые в них появляются. В настоящих глазах они одинаковые, в поддельных – разные. К примеру, отражение в левом глазу не такое, как в правом.

Итого: фейки можно распознать либо по зрачкам неправильной формы, либо увидев разные отражения в глазах. Пока так. Хотя со временем, искусственный интеллект поумнеет и найдёт способ исправить подделки. Но люди придумают, как все-таки подловить такое творение.

По материалам «Комсомольская правда». Автор Владимир Лаговский