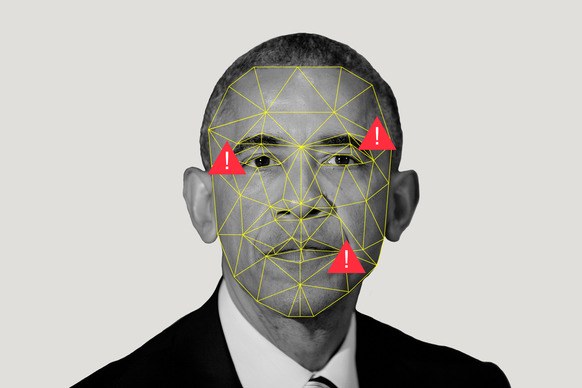

В 2020 году появилось несколько новых способов обмана с использование сгенерированных данных. Для этого мошенники подделывают как голоса, так и манеру речи

Год: 2020

Ещё вчера все говорили про опасность алгоритмов, генерирующих поддельные изображения и голос. Обсуждалась возможность использования этих алгоритмов в конструктивных целях. Но такие алгоритмы уже вчерашний день. 2021 год ознаменуется появлением более опасных алгоритмов: алгоритмов, которые понимают причину тех или иных действий и подстраиваются под наше психологическое восприятие. Социальная инженерия автоматизируется и ставится на поток

Обработка занимает от нескольких минут до нескольких часов — все зависит от загрузки сервера. Максимальная длина сообщения — 200 символов. Все обращения проверяют модераторы и удаляют тексты, которые содержат непристойности или оскорбления

RT выпустил шуточный ролик, в котором представил, о чём разговаривают со своими психологами ведущие политики мира в преддверии 15-летия телеканала

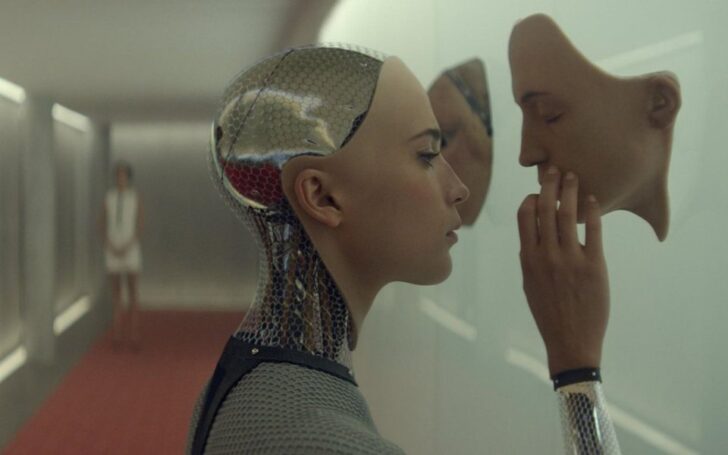

В первом ролике рассказывается, что такое deepfake и почему не стоит доверять всему, что видите

Во втором ролике, Анна рассказывает о пяти приложениях, с помощью которых можно легко и быстро создать deepfake video

Большая часть компаний по развитию технологий дипфейков сосредоточена в США и Китае. В России – Dowell (входит в Everypixel Group), AvaTunes и Vera voice

В проекте постановления указано, что решение об использовании ЕБС будут принимать вузы в добровольном порядке. Если такое решение будет принято, то студентам придется сходить в отделение банка, оснащенное системой сбора биометрии, сфотографироваться и оставить образец голоса.

В пресс-центре МВД России сообщили, что с начала года полиция возбудила 37 уголовных дел за распространение фейковой информации о коронавирусе и более 450 протоколов об административных правонарушениях, передает ТАСС

У вас, вероятно, также был опыт, когда кто-то выкрикивал ваше имя, чтобы позвонить вас или когото еще с похожим именем, и ваши уши настораживались

Знаменитый мексиканский журналист Хавьер Вальдес, убитый наркомафией в 2017 году, вновь «ожил» с помощью искусственного интеллекта, нейросетей и IT-специалистов из России, и начал обвинять президента и правительство

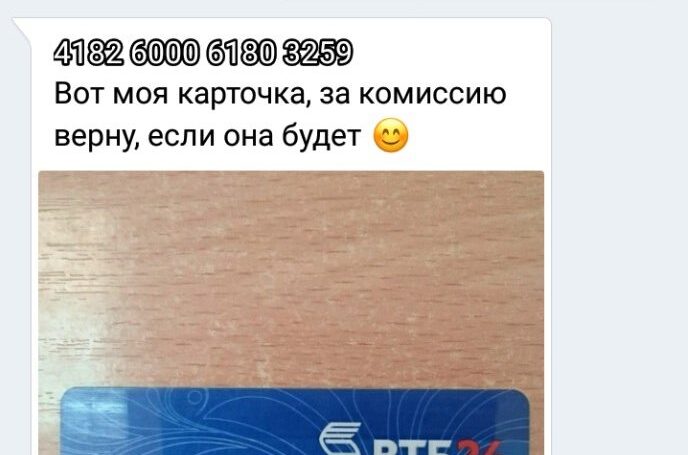

Эксперты компании «Инфосистемы Джет» предупредили о новом способе обмана в интернете, когда мошенники выманивают деньги у жертв

Znak.com поговорил с Марией Чмир основательницей и генеральным директором стартапа Dowell — компании, развивающей технологию Deepfake.

Люди теперь проводят большую часть своей жизни в интернете, в котором аккумулируется огромное количество информации, и их деятельность в сети может создавать и разрушать репутацию человека. Такая информационная онлайн-среда идеально подходит для занятия преступной деятельностью, основанной на искусственном интеллекте

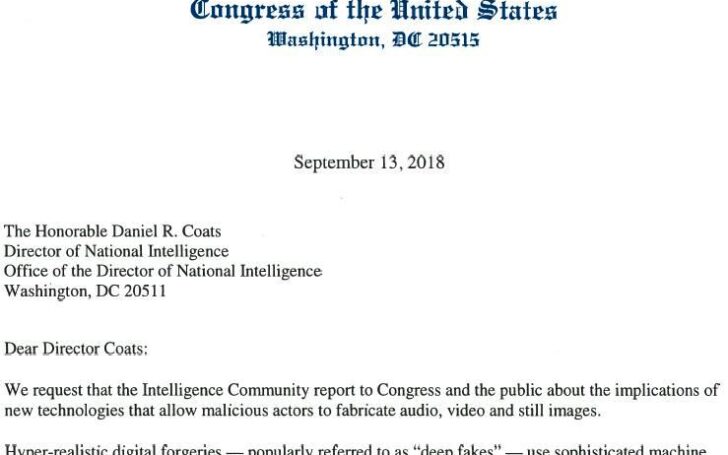

После обращения Конгресса США из открытого доступа исчезли все программные продукты, которые позволяли создавать глубокие подделки

Эти видео — не те дипфейки, которые предназначены для подрыва демократии и информационной войны. Они даже не особо убедительны, скорее, просто забавны

Tencent перечислила пять примеров полезного применения технологии дипфейков, которые уже существуют или могут скоро появиться

Реклама с виртуальными моделями, цифровые телеведущие и фейковые речи президентов – реальность, которую формируют алгоритмы машинного обучения. В 2020 году технологии искусственного интеллекта глубже проникают в сферы телекоммуникаций, развлечений и формируют новые рынки. За развитием дипфейков внимательно наблюдают специалисты по кибербезопасности, расследуя новые формы мошенничества с использованием передовых технологий

Маски делают абсолютно реалистичными: на них есть веснушки, мелкие и крупные мимические морщины и главное – они повторяют все мимические движения

Отмечается, что компания ищет «доброе и дружелюбное лицо», так как будущие роботы будут помогать пожилыми людьми. Всем заинтересованным стартап предлагает отправить свое фото на почту

Преобразование голоса – это средство преобразования одного голоса в другой, методика изменения формы волны речи для преобразования нелингвистической информации при сохранении языковой информации (например, одни и те же слова, другой голос).

Обычно для качественного синтеза речи с помощью технологии TTS нужно не меньше 20 часов речи в записи, но у команды было только четыре минуты

«Гарантия того, что снимается селфи от живого человека, а не с фотографии другого снимка, маски или видео, является одновременно технически сложной и критически важной. Сделать это пассивно, без каких-либо действий со стороны пользователя – это вишенка на торте»

Фотография поддельной кредитной карты генерируется специальной программой. Для этого необходимо ввести имя владельца взломанного аккаунта и номер настоящей кредитной карты кибермошенника, на которую будут переводиться деньги. Ранее для этого злоумышленники использовали программу Photoshop

Хочется напомнить о существовании Photoshop. В своё время он сильно изменил мир. Тем не менее человечество адаптировалось, также будет и с Deepfake

Для будущих публикаций проблема теоретически будет решена, но остается проблема архивов: защищая только вновь создаваемый контент – это не окажет практически никакого влияния на уже размещённые материалы